一言以蔽之:通過直接在記憶體中執行計算,可以提高AI處理器的速度和效率。

自從ChatGPT問世以來,由於它能提供比Google搜尋更直接的答案,所以被很多媒體預測為挑戰Google霸主地位的潛力新秀,微軟也趁勢將ChatGPT整合進其搜尋引擎Bing內,試圖領先Google。然而媒體同時也報導了,AI運算背後的高昂成本。

Open AI的執行長曾透過推特表示,ChatGPT的營運成本令人瞠目結舌。根據計算,ChatGPT生成一條資訊或回覆的成本落在1.3美分左右,是目前傳統搜尋引擎的3至4倍。數據分析顯示,Google去年共計3.3萬億次的搜尋中,平均每次的成本僅有0.2美分。

Google想加入AI搜尋大戰,錢夠了嗎?董事長曝成本暴增10倍,一年可能要燒60億(2023/02/24@數位時代)

AI熱潮蓬勃發展,會大幅增加晶片和電力的成本負擔。我們都知道,擅長平行運算的GPU比CPU更適合用在AI訓練,因為GPU包含了很多arithmetic logic unit算術邏輯單元,使其能夠同時執行數千個乘法和加法,然而GPU本意是被設計來繪圖的,作為一種通用處理器,必須支持各種不同的應用程序,而不是專門做AI的,於是乎就有專門算AI的ASIC出現了,例如TPU是tensor processing unit張量處理器,由Google設計的矩陣處理器,就不是通用處理器。

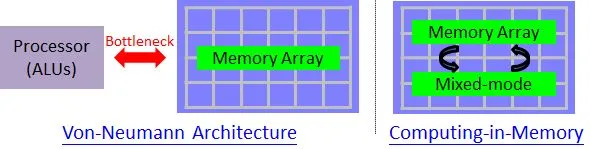

另外,傳統的處理器使用Von-Neumann architecture(馮紐曼架構指的是計算裝置分為五個部分——算術邏輯單元、控制單元、記憶體、輸入、輸出,各司其職)。馮紐曼架構把程式二進位編碼後儲存於記憶體中,算術邏輯單元要自記憶體中讀取指令和資料來執行。這樣會遇到Von-Neumann bottleneck,也就是處理器在記憶體搬運資料會花掉大量的時間和能源,因此記憶體內運算(in-memory computation)就成為AI處理器的顯學,近幾年的ISSCC有很多篇在討論這類主題的論文。

與依賴消耗過多功率的高傳輸量DRAM的數位運算系統不同,記憶體內類比運算(analog compute in-memory,CIM)系統可以利用令人難以置信的高密度快閃記憶體進行資料儲存和運算,這樣就消除了在數位運算系統中訪問和維持DRAM中的資料所帶來的高功耗。使用類比CIM方法後的處理器能以快速和低功耗的方式操作和組合整個儲存庫中的小電流從而在揮發性儲存單元內完成算數運算。

類比運算將是下一個人工智慧創新時代的關鍵(2022/03/23@EE Times)

擁抱科技浪潮AI運算,也要維持環境永續。雖然目前GPU是deep learning最常見的架構,但未來必然會被TPU(或其他AI處理器APU)所取代。